{{ v.name }}

{{ v.cls }}类

{{ v.price }} ¥{{ v.price }}

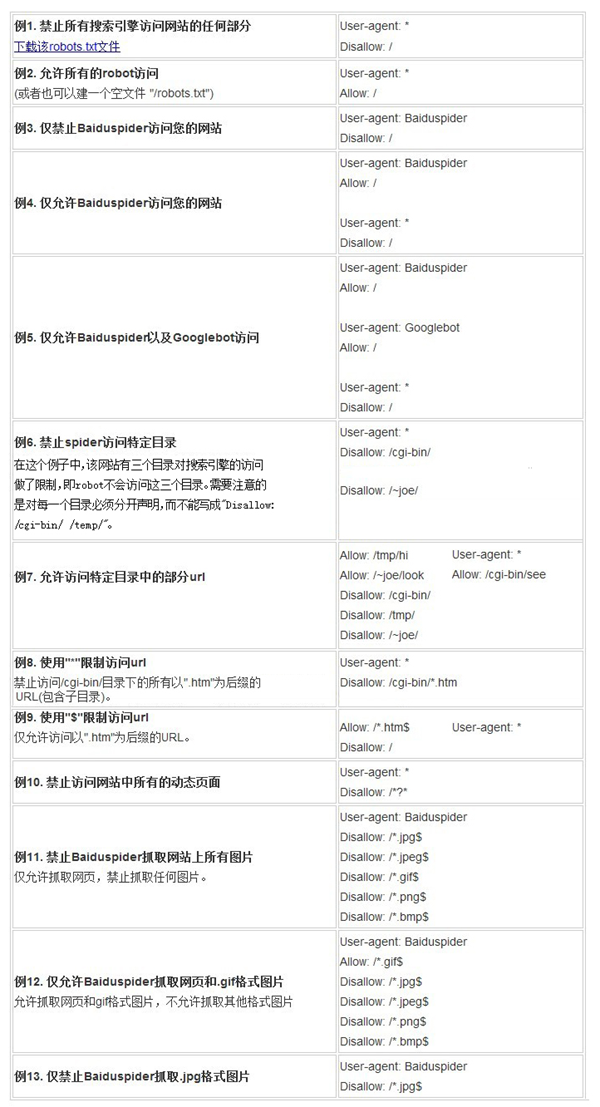

robots文件其实就是一个网站的权限清单,一般只针对网站做SEO优化。你可以在robots文件里面写上哪些网站目录和链接允许被搜索引擎抓取,哪些被不允许抓取收录。

robots文件常用写法:

User-agent: *

Disallow:/

robots协议放哪里?

不想让搜索引擎收录,可以通过上面的代码来屏蔽搜索引擎。

把文件重命名为robots.txt,再把robots.txt通过FTP等方式放到网站根目录下。

robots协议如何屏蔽所有搜索引擎?

User-agent: *

Disallow:/

robots.txt的写法规则

User-agent: * 符号*为通配符 代表所有的搜索引擎种类。

代码Disallow: 表示禁止搜索引擎爬取及收录 用法如下

Disallow: /admin/ 比如禁止爬寻admin(admin一般为网站管理后台)的目录

Disallow: /ABC/ 举例abc目录 禁止任何搜索引擎爬取收录网站里为ABC的目录及其子目录

Disallow: *.htm 禁止访问目录下的所有以".htm"为后缀的URL(包含子目录)。

Disallow: /*?* 禁止访问网站中所有的动态页面

Disallow: /jpg$ 禁止抓取网页所有的.jpg格式的图片

Disallow:/abc/abc.html 禁止爬去abc文件夹下面的abc.html文件。

代码Allow: 表示允许搜索引擎爬取及收录 用法如下

允许爬取及收录

Allow: /abc/ 这里定义是允许爬寻cgi-bin目录下面的目录

Allow: * 这里定义是允许爬全站任何文件及目录

Allow: .htm$ 仅允许访问以".htm"为后缀的URL。

Allow: .gif$ 允许抓取网页和gif格式图片

robots代码参考大全:

还有一种允许搜索引擎抓取网站全部内容的方式就是robots.txt为空或者不创建robots.txt文件

以上就是苏州网站建设公司同乾传媒为大家做的网站robots.txt文件用法举例,robots.txt对网站SEO优化和排名极其重要,熟悉了解后再使用请勿随意使用不然会引起不必要的错误状况。